硬核观察 #1233 基于源代码的 Gentoo Linux 也将提供二进制

1 基于源代码的 Gentoo Linux 也将提供二进制

Gentoo Linux 是最著名的基于源代码的 Linux 发行版之一。但最近,Gentoo 称,“为了加快使用慢速硬件的速度,也为了整体方便,我们现在也提供二进制软件包供下载和直接安装!”在他们的镜像服务器中,从 LibreOffice 到 KDE Plasma,从 Gnome 到 Docker,有超过 20 GB 的软件包。Gentoo 将每日更新其 amd64 和 arm64 稳定版软件仓库,用户可以自由混合安装源码包和二进制包。

(插图:DA/f8c25f79-1415-400b-a981-3fdb69980c3b)

消息来源:Gentoo

老王点评:虽然这让最终用户更方便,但是 Gentoo 用户不就是奔着自己编译源代码来的吗?

2 树莓派比 1978 年的 Cray-1 超级计算机快四倍以上

罗伊·隆巴顿 从 1972 年到 2022 年,制作并运行了计算机基准测试和压力测试程序,他被誉为 Whetstone 基准的官方设计权威。在 2019 年,84 岁的隆巴顿受邀成为树莓派预发布的 Alpha 测试团队的志愿成员。本周,已经 87 岁的隆巴顿分享了 Cray-1 超级计算机与家用电脑、手机和平板电脑的 性能比较。1978 年的 Cray-1 超级计算机耗资 700 万美元,重达 10500 磅,功率为 115 千瓦,它是当时世界上速度最快的计算机。而树莓派的成本约为 70 美元,仅重几盎司,使用 5 瓦电源,其速度是 Cray-1 的 4.5 倍以上。

(插图:DA/06516279-2475-4f69-89d5-73edf3c85fed)

消息来源:Slashdot

老王点评:这才仅仅过去几十年,或许十年后的个人设备都拥有现在超算的计算和存储能力。所以,我的观点是,技术的进步其实就是基础设施的进步。

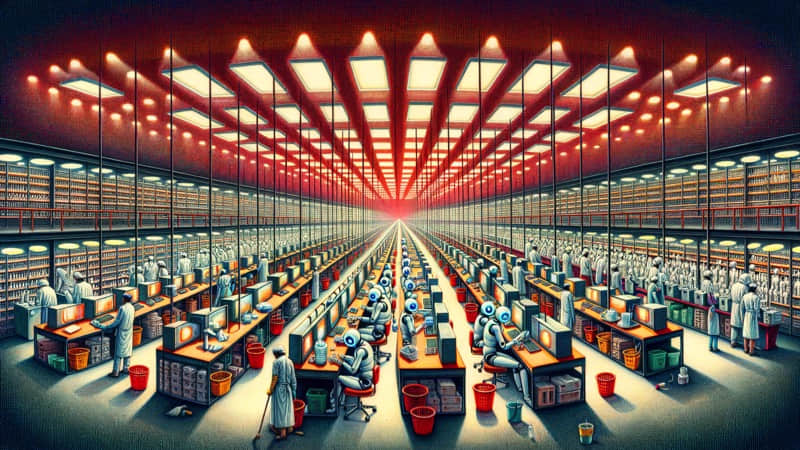

3 AI 将成为你的同事,或者取代你的职位

大型语言模型已经准备从生成合成内容的人工智能聊天机器人,发展成为能够在你的办公桌上对你的电脑执行操作的虚拟 智能体 。新一波智能体初创公司正在打造能够自动处理日常工作的产品。初创公司 Lindy 的 CEO 说,“人们总是担心机器人会抢走人们的工作。我认为是人们抢了机器人的饭碗”。人工智能助手与人类一起工作的想法已经成为主流,微软打造了 Copilot for Microsoft 365,而谷歌则为其工作空间提供了 Duet AI。一些人认为,这意味着人类可以减少工作,追求自己的爱好和兴趣,而更悲观的人则认为,由软件辅助的工人只会被推着生产更多的产品。

(插图:DA/efc77009-ea61-45a3-adf3-d4f16d4993a5)

消息来源:The Register

老王点评:不,人类只需要领着最低基本收入被养着,然后淘汰无用的躯体。