上海外滩大会,你不可不知的五大技术看点

明天,「Inclusion 外滩大会」就要开幕了,在这场全球金融科技盛会中,作为金融业的得力助手,科技主题,也占据了不少的篇幅。而作为 IT 人,如果你来到了外滩大会,那么下面这些技术分享,一定不能错过。

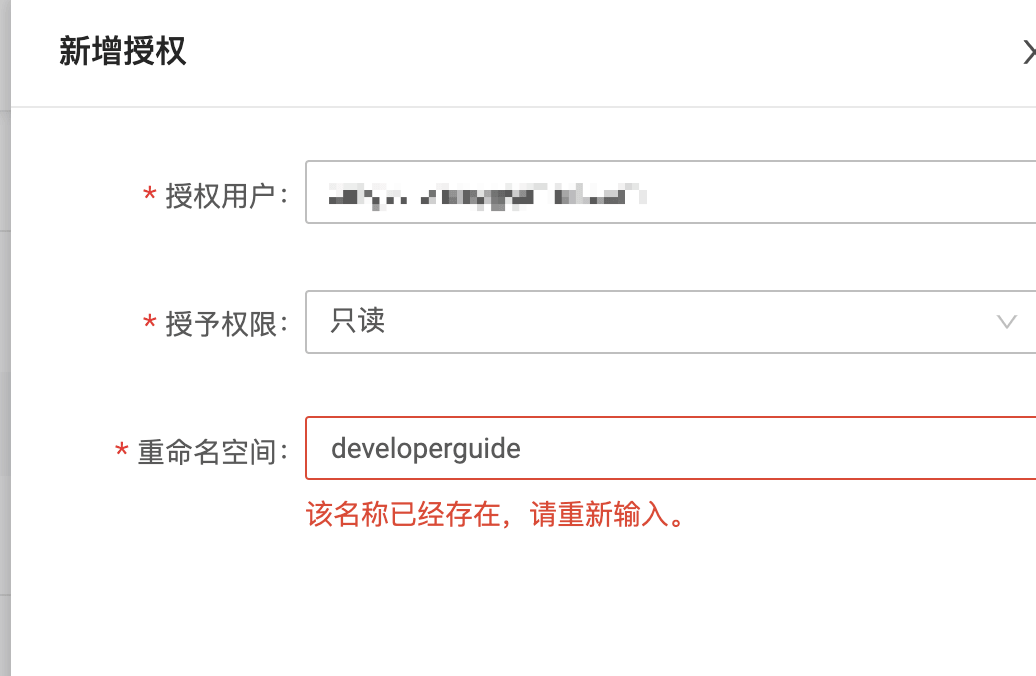

必看一:OceanBase 是怎样炼成的?

作为一切 IT 应用的基础,数据库是每一场技术大会都必不可少的主题。而随着云计算时代的到来,数据库领域也发生了天翻地覆般的改变。互联网的海量应用场景给了数据库技术最肥沃的试验田。而自研数据库技术得益于国内海量的数据应用,快速创新,持续蓄力。

作为自研数据库的翘楚,OceanBase 是谈及自研数据库绕不过去的话题,在本次的 Inclusion 大会中,主办方邀请了 OceanBase 团队的首席技术官阳振坤博士,来「数据库,新标杆,新征途」分会场分享「OceanBase 数据库七亿 tpmC 的关键技术」

除了 OceanBase 以外,关于数据库,主办方还邀请了华东师范大学副院长,“智能+”研究院院长,数据学院教授周傲英博士分享「数据库的发展与中国的机遇」、西安银行科技部总架构师肖梁先生分享「企业级数据库加速客户数字化转型」、恒生电子股份有限公司云基础系统发展部总经理王佳玮分享「证券行业数据库应用创新之路」等。如果你对数据库感兴趣,那么一定不能错过「数据库,新标杆,新征途」分会场所分享的各种技术主题。

必看二:智能驱动金融变革

人工智能、分布式计算等新技术,引领了当下技术的潮流,更是将金融科技推向了新的发展高度。在新的时代,金融的创新更多的依赖这些新兴技术所带来的改变和智能与技术所引导的业务创新场景。在本次大会中,主办方邀请了全球顶级思想领袖、技术大咖和学术精英共同探讨在新的技术潮流下,金融科技将何去何从?

在本次的 Inclusion 大会中,蚂蚁集团副总裁芮雄文将会就新技术潮流下的金融科技这一话题,在「智能计算峰会 - 重塑金融」分会场分享「新时代新要求:科技重塑金融创新」。

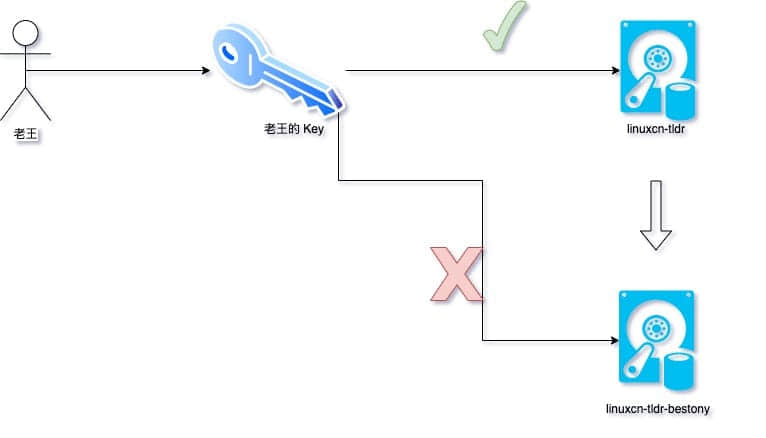

不仅如此,蚂蚁集团副总裁韦韬将会分享「安全计算的演变与展望」,介绍蚂蚁集团是如何让计算变得更加安全和可信。

此外,你还可以在「智能计算峰会 - 重塑金融」分会场听到来自蚂蚁集团的计算存储首席架构师何昌华分享「智能计算实践」、美国三院院士,曾获冯诺依曼奖的 Michael Jordan 分享「人工智能发展趋势」以及恒生电子股份有限公司总裁刘曙峰分享「智能化推进金融数字化下半场」等主题。

如果你关注人工智能、机器学习、那么「智能计算峰会 - 重塑金融」,将是你不容错过的一场。

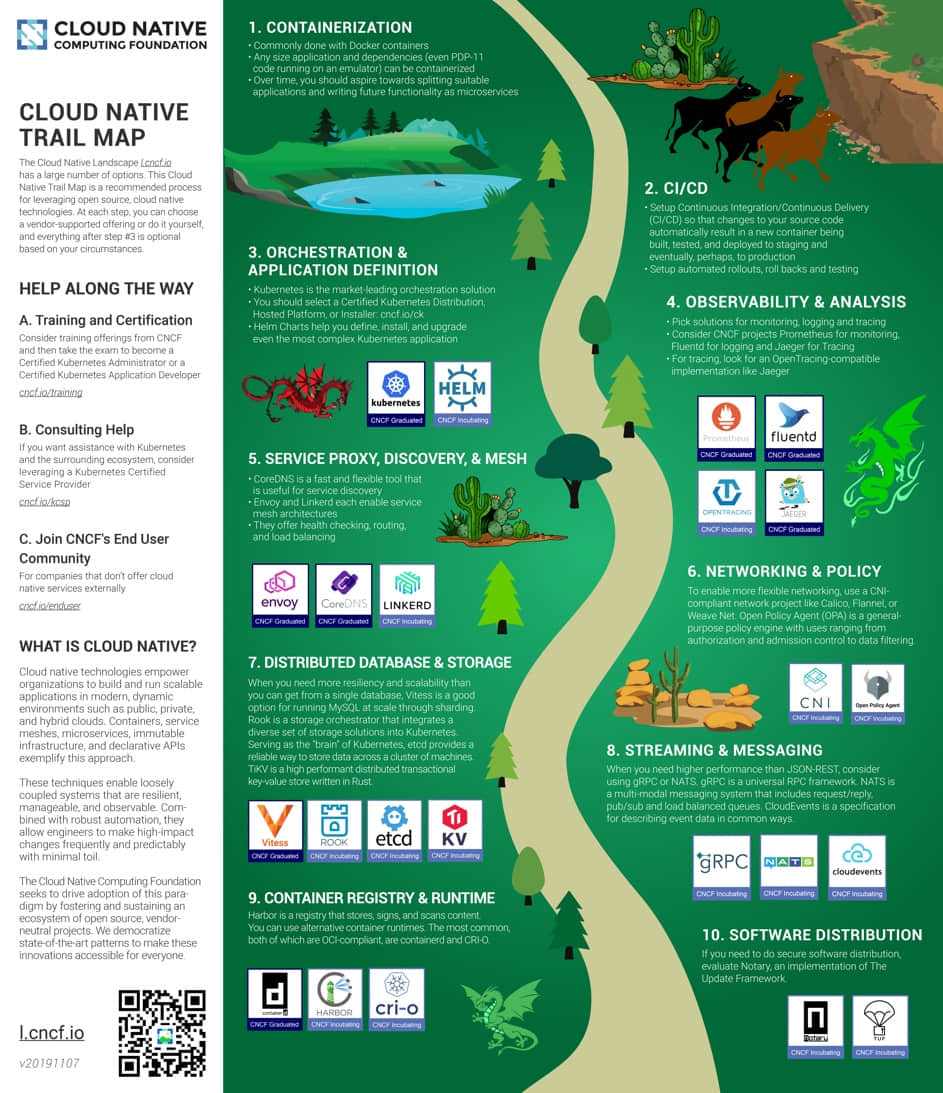

必看三:如何构建可信原生

云原生理念和实践已经取得了广泛的认可和传播,云原生的关键技术也在不断发展,提升IT系统的生产力,然而在注重信任的金融领域,如何在利用云原生带来的效能提升的同时,进一步提升安全和稳定性,仍然是个极具挑战的问题。为了更好的讨论这个问题,本次大会的主办方邀请了蚂蚁集团研究员何征宇在「可信原生 - 安全稳定的基础设施」分享「可信原生: 下一代的金融技术基础设施」。

除了下一代金融技术基础设施的分享以外,「可信原生 - 安全稳定的基础设施」分会场还邀请了陈渝副教授分享「基于 Rust 语言的 OS 探索」和英特尔 IAGS 系统软件 高级技术总监刘秉伟分享「英特尔系统全栈,赋能机密计算新时代」。

未来,每一个金融云,都将会基于可信原生建立,那么在现在,就是来了解他的最好时刻。

必看四:技术风险控制的实现秘诀

随着企业数字化转型的不断推进,越来越多的新兴技术开始出现在企业的各种应用中,这些应用改变了行业,但也同样带来了足以改变行业的问题。在这样的大背景下,控制技术因素引入的稳定性风险就显得日趋重要。在本次大会的「技术风险,稳妥创新」分会场,云集了蚂蚁集团、中国人寿、滴滴等多个企业的技术专家,一同探讨如何在企业内进行技术风险的控制。

在「技术风险,稳妥创新」分会场中,以下主题不容错过:

必看五:创新引领未来

产学研的打通,促进了研究的落地发芽,推进了产业和学界的交流和沟通,更是为行业和国家培养了一批又一批的优秀人才,在这次大会中,蚂蚁集团联合产学研机构,邀请了国内外优秀学者共话如何推进计算机科学领域基础性、前瞻性的技术发展和人才培养。在本次外滩大会的「校企合作 - 引领技术 、关注人才、共创未来关注」分会场,你将会了解到全世界高校的尖端研究与新时代下产学研如何合作、共进、共研。

在「校企合作」分论坛,主办方邀请了教育部高等教育司巡视员兼教育部高等教育教学评估中心主任刘凤泰分享「新时代下的校企合作探索与思考」

除了这些,还有什么值得看?

如果上面的这五个会场你还觉得不够,Inclusion 外滩大会还有其他的分论坛,可以满足你对于技术的一切要求,比如:

- 实时智能分论坛:专注实时计算系统和下一代数据存储于计算领域的创新与应用

- 图智能分论坛:了解复杂金融关系的最优解 —— 图智能

- 体验科技分论坛:探讨新一代极致的用户体验及最佳工程实践

- AI 安全分论坛:在新的安全形式下,如何推动和引领业界在AI安全领域的发展?

- IoT 安全分论坛:在 IoT 新时代,如何在服务模式业务创新的基础上,保障用户的安全和隐私?

当然,整个 Inclusion 外滩大会不止这些,更多的好内容,你可以访问官网 www.inclusionconf.com 了解。

总结

Inclusion 大会作为一场全球金融科技盛会,在科技领域能够邀请如此多的行业专家、学者来一同讨论金融科技的现在与未来,对于每一个从业者来说,都是不可多得的机会。如果你有机会来到外滩大会,一定不要错过这些精彩的分享,来听一听技术专家的分享。